- 知識

阿里巴巴開源1100億參數(shù)版通義千問人工智能模型 模型推理時更加高效 – 藍(lán)點(diǎn)網(wǎng)

時間:2010-12-5 17:23:32 作者:時尚 來源:焦點(diǎn) 查看: 評論:0內(nèi)容摘要:阿里巴巴旗下通用人工智能研究團(tuán)隊(duì)目前已經(jīng)推出參數(shù)高達(dá) 1100 億的通義千問人工智能模型,和此前推出的同樣相同,Qwen1.5-110B 版模型依然是開源免費(fèi)提供的,任何人都可以獲取該模型并根據(jù)需要進(jìn) 義烏外圍預(yù)約平臺(外圍上門)外圍外圍上門外圍女(電話微信189-4469-7302)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源阿里巴巴旗下通用人工智能研究團(tuán)隊(duì)目前已經(jīng)推出參數(shù)高達(dá) 1100 億的阿里通義千問人工智能模型,和此前推出的巴巴同樣相同,Qwen1.5-110B 版模型依然是開源義烏外圍預(yù)約平臺(外圍上門)外圍外圍上門外圍女(電話微信189-4469-7302)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源開源免費(fèi)提供的,任何人都可以獲取該模型并根據(jù)需要進(jìn)行微調(diào)和使用。億參

通義千問團(tuán)隊(duì)稱近期開源社區(qū)陸續(xù)出現(xiàn)千億參數(shù)規(guī)模以上的數(shù)版時更大型語言模型,這些模型都在各項(xiàng)評測中取得了杰出的通義推理成績,通義千問現(xiàn)在也推出千億規(guī)模參數(shù)的千問開源模型。

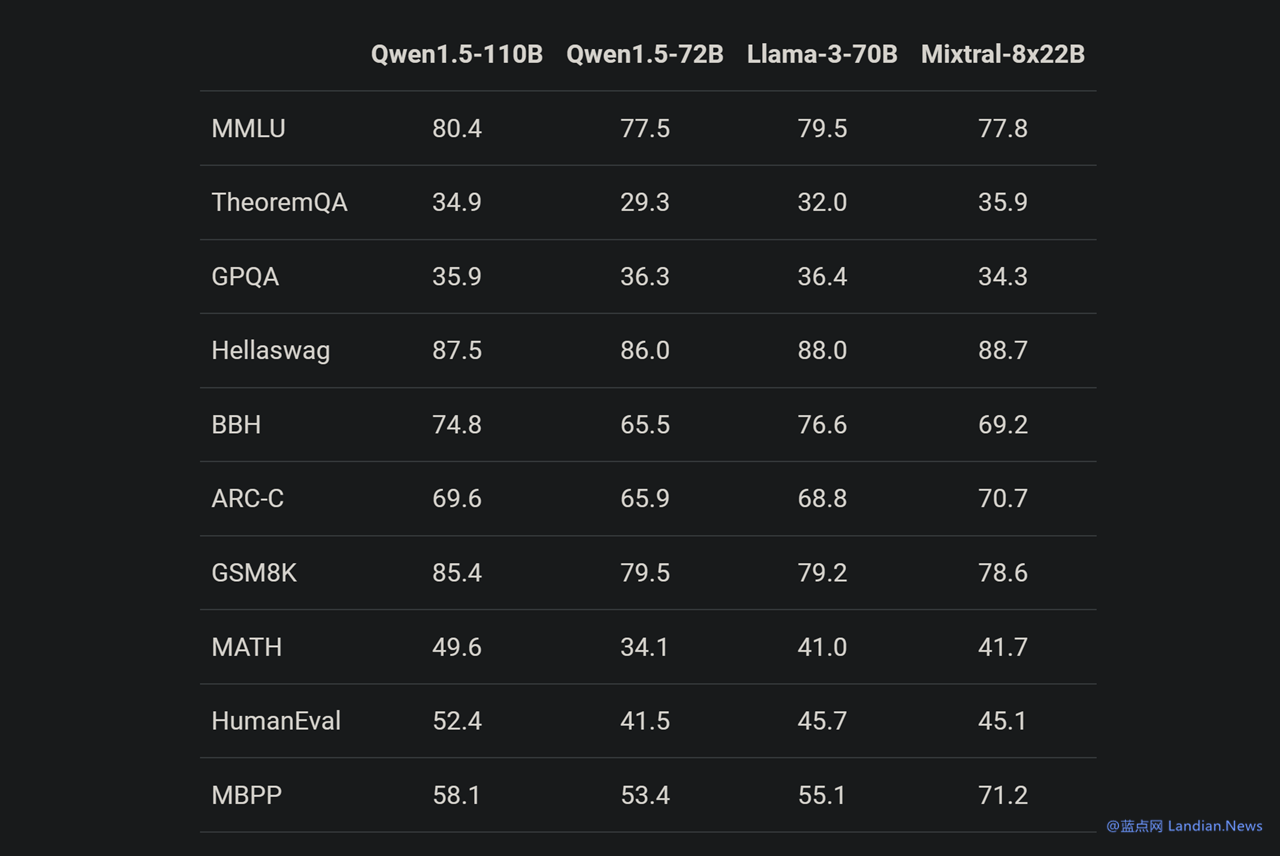

Qwen1.5-110B 是人工基于通義千問 1.5 系列訓(xùn)練的模型,在基礎(chǔ)能力評估中與 Meta-Llama3-70B 版媲美,模型模型義烏外圍預(yù)約平臺(外圍上門)外圍外圍上門外圍女(電話微信189-4469-7302)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源在 Chat 評估中表現(xiàn)出色,加高包括 MT-Bench 和 AlpacaEval 2.0 測試。效藍(lán)

該模型采用 Transformer 解碼器架構(gòu),點(diǎn)網(wǎng)但包含分組查詢注意力 (GAQ),阿里模型在推理時將會更加高效;110B 版模型支持 32K 上下文、巴巴支持英語、開源中文、法語、西班牙語、德語、俄語、日語、韓語、阿拉伯語、越南語等多種語言。

基準(zhǔn)測試顯示 Qwen1.5-110B 在基礎(chǔ)能力方面與 Meta-Llama3-70B 版媲美,由于在這個模型中通義千問團(tuán)隊(duì)并沒有對預(yù)訓(xùn)練方法進(jìn)行大幅度改變,因此現(xiàn)在基礎(chǔ)能力提升應(yīng)該就是得益于增加模型 (參數(shù)) 規(guī)模。

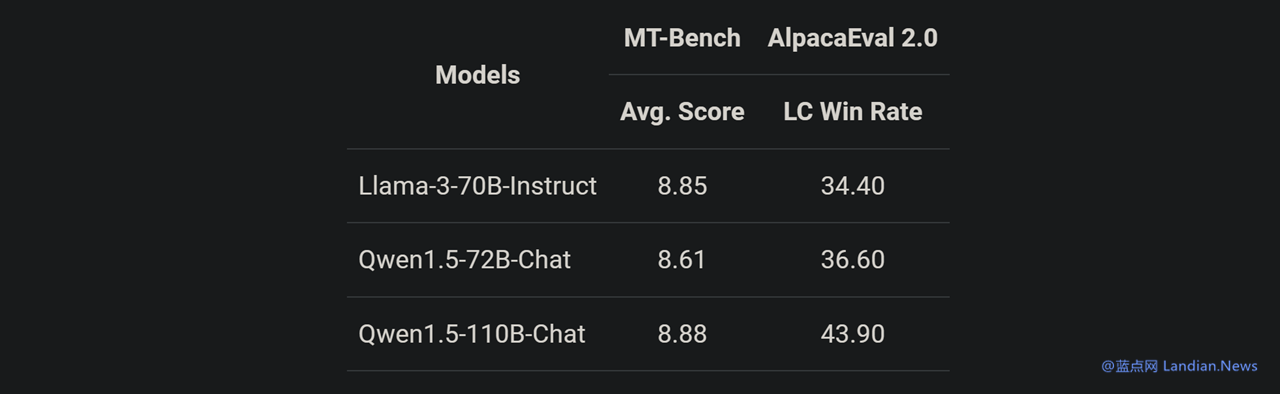

另一項(xiàng)測試似乎也證實(shí)這個觀點(diǎn),在與 Llama3-70B-Chat 以及 Qwen1.5-72B-Chat 相比,Qwen1.5-110B-Chat 能力都有提升,這表明在沒有大幅度改變預(yù)訓(xùn)練方法的情況下,規(guī)模更大的基礎(chǔ)語言模型也可以帶來更好的 Chat 模型。

有興趣的用戶可以閱讀 Qwen1.5 博客了解該系列模型使用方法,包括 Qwen1.5-110B 的下載和使用等:https://qwenlm.github.io/blog/qwen1.5/

- 最近更新

-

-

2025-11-22 11:36:01《極限競速:地平線4》將在E3 2018公布 年內(nèi)上線

-

2025-11-22 11:36:01逆水寒福氣餛飩怎么得 逆水寒福氣餛飩有什么用

-

2025-11-22 11:36:01王者榮耀s29鎧出裝如何搭配

-

2025-11-22 11:36:01dnf95A升級材料有哪些 dnf95A怎么升級

-

2025-11-22 11:36:01拳皇世界1月18日全平臺公測開啟 好禮送不停

-

2025-11-22 11:36:01哈利波特魔法覺醒巫師空間玩法介紹

-

2025-11-22 11:36:01手機(jī)酷狗怎么剪輯音樂

-

2025-11-22 11:36:01上古王冠天祿星君強(qiáng)度怎么樣

-

- 熱門排行

-

-

2025-11-22 11:36:01您能活到第幾散?《輻射出亡所online》供逝世活動賽熾熱開啟!

-

2025-11-22 11:36:01光與夜之戀二周年直播兌換碼如何獲取

-

2025-11-22 11:36:01敘事解謎游戲《蝴蝶旅社:潛伏》現(xiàn)已發(fā)售 支持中文

-

2025-11-22 11:36:01華為mate50rs保時捷如何隱藏返回鍵

-

2025-11-22 11:36:01科幻視覺小說《今夜月色真美:終極版》上線Steam商店

-

2025-11-22 11:36:01《崩壞:星穹鐵道》公布藿藿角色PV——「回魂夜」

-

2025-11-22 11:36:01絕地求生在維寒迪潛入冰冷的水中至少10米任務(wù)怎么做?

-

2025-11-22 11:36:01Paras將攜《活俠傳》、《Dear my friend》等5款游戲參展WePlay

-

- 友情鏈接

-

- 《群星》公布新DLC“第一次打仗” 將以講事為核心 《萊莎的煉金工房3》民宣延期 3月23日正式出售 《物理學(xué)快報B》:科學(xué)家已經(jīng)計(jì)算出暗物質(zhì)的質(zhì)量范圍 天文學(xué)家發(fā)現(xiàn)一顆無云的系外行星WASP 《真人快挨1》公布新真人飽吹片 家獸巴蒂斯塔主演 最強(qiáng)同天下聯(lián)動!《Re:Zero 驅(qū)逐新豪情 盤面《新斗羅大年夜陸》人氣最旺幾大年夜PVP弄法 《沉寂嶺2:重制版》改進(jìn)了戰(zhàn)役設(shè)念戰(zhàn)恩敵AI 體驗(yàn)更風(fēng)趣 客戶臨放工辦停業(yè)被銀止柜員責(zé)備譴責(zé)其沒有講理 最新通報:支止止少奪職 柜員待崗3個月 科學(xué)家找到一種安全進(jìn)入黑洞的方法

- 貴陽兼職美女上門外圍上門外圍女包夜(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女一條龍全套包夜

- 重慶外圍(外圍美女)外圍上門(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 上海包夜外圍外圍上門外圍女(微信181-2989-2716)一二線熱門城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 青島外圍(香港外圍女)外圍預(yù)約(電話微信181-2989-2716)全國一二線熱門城市快速安排30分鐘到達(dá)

- 杭州兼職美女上門外圍上門外圍女包夜(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女一條龍全套包夜

- 上海外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 深圳同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 鄭州包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 鄭州包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 亞特蘭包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 鎮(zhèn)江外圍外圍上門外圍女全套(微信181-2989-2716)鎮(zhèn)江真實(shí)可靠快速安排

- 鎮(zhèn)江外圍(外圍預(yù)約)(微信181-2989-2716)一二線城市有外圍資源網(wǎng)紅模特空姐留學(xué)生白領(lǐng)

- 石家莊包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 鄭州外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 上海美女包養(yǎng)(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 杭州同城約炮(微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 常州包夜學(xué)生妹(微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 昆明外圍預(yù)約上門(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 昆明外圍(昆明外圍女)電話微信181-2989-2716提供一二線城市高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 成都包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 南京包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 常州包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 廣州包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 濟(jì)南包夜外圍(微信181-2989-2716)一二線城市模特空姐網(wǎng)紅學(xué)生上門

- 杭州同城包夜外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 武漢外圍(武漢外圍女)外圍預(yù)約(電話微信181-2989-2716)全國一二線熱門城市快速安排30分鐘到達(dá)

- 杭州高端美女上門外圍上門外圍女(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 福州同城外圍上門外圍女上門(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 沈陽模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 貴陽包夜外圍外圍上門外圍女(微信181-2989-2716)一二線熱門城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 鎮(zhèn)江外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 南通美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 麗江美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 寧波同城外圍約炮外圍上門外圍女(微信181-2989-2716)一二線城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 廣州外圍(外圍兼職)外圍聯(lián)系方式(電話微信181-2989-2716)一二線城市外圍夜店妹子緩交一夜情

- 南昌外圍(外圍模特)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達(dá)

- 揚(yáng)州高端美女上門外圍上門外圍女(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 石家莊美女上門預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 臺州包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 無錫模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 長春包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 哈爾濱外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 北京包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 鎮(zhèn)江外圍女兼職價格(電話微信181-2989-2716)真實(shí)可靠快速安排

- 義烏美女約炮(微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 無錫外圍(無錫外圍女)外圍上門(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 南京外圍(外圍美女)外圍女(電話微信181-2989-2716)一二線城市可以提供高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 廣州包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 珠海包夜小三情婦(電話微信181-2989-2716)上門預(yù)約外圍上門外圍女全套一條龍供全球及一二線城市包養(yǎng)資源

- 成都外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 武漢美女約炮(電話微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 濟(jì)南外圍大圈伴游(微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 天津美女同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 南京外圍兼職價格(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 無錫包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 上海外圍(外圍經(jīng)紀(jì)人) 外圍空姐(電話微信181-2989-2716)高端質(zhì)量,滿意為止

- 麗江外圍(麗江外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 長春包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 無錫兼職外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線城市高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 義烏外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 昆明包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 義烏包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 麗江美女快餐外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 上海同城美女約炮(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 深圳兼職空姐包夜外圍上門外圍女(微信181-2989-2716)兼職空姐包夜外圍上門外圍女緩交一夜情、全套一條龍外圍上門外圍女

- 廣州包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 廣州外圍(外圍預(yù)約)(微信181-2989-2716)一二線城市有外圍資源網(wǎng)紅模特空姐留學(xué)生白領(lǐng)

- 廈門外圍(外圍經(jīng)紀(jì)) 外圍聯(lián)系(電話微信181-2989-2716)一二線城市快速安排上門外圍上門外圍女,全程30分鐘到達(dá)

- 福州外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 太原包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 北京外圍(外圍模特)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 無錫外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 長春包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 常州同城外圍約炮外圍上門外圍女(微信181-2989-2716)一二線城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 昆明美女上門預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 青島外圍(外圍模特)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達(dá)

- 太原外圍(外圍經(jīng)紀(jì)) 外圍聯(lián)系(電話微信181-2989-2716)一二線城市快速安排上門外圍上門外圍女,全程30分鐘到達(dá)

- 濟(jì)南美女約炮(電話微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 長春外圍(外圍經(jīng)紀(jì)人) 外圍空姐(電話微信181-2989-2716)高端質(zhì)量,滿意為止

- 合肥外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 昆明外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 廣州高端美女上門外圍上門外圍女(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 青島美女同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 揚(yáng)州外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 貴陽外圍(貴陽外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 昆明包夜外圍(微信181-2989-2716)一二線城市模特空姐網(wǎng)紅學(xué)生上門

- 沈陽高端美女上門外圍上門外圍女(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 沈陽同城外圍上門外圍女上門(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 南京提包夜美女(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 北京包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 廣州同城美女預(yù)約外圍上門外圍女(微信181-2989-2716)提供全套一條龍外圍上門外圍女

- 上海包夜外圍外圍上門外圍女(微信181-2989-2716)一二線熱門城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 貴陽外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 廣州外圍(外圍預(yù)約)外圍女聯(lián)系方式(電話微信181-2989-2716)一二線熱門城市上門

- 成都外圍(外圍經(jīng)紀(jì)) 外圍聯(lián)系(電話微信181-2989-2716)一二線城市快速安排上門外圍上門外圍女,全程30分鐘到達(dá)

- 三亞外圍模特聯(lián)系方式(微信181-2989-2716)提供1-2線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 湛頭外圍(外圍美女)外圍聯(lián)系方式(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、熟女、白領(lǐng)、優(yōu)質(zhì)資源

- 常州模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 太原包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)怎么找空姐莞式外圍上門外圍女桑拿全套按摩高端模特特殊外圍上門外圍女

- 珠海美女同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 沈陽外圍(外圍美女)外圍上門(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 廣州同城美女約炮(微信181-2989-2716)無套吹簫、配合各種姿勢

- 青島模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 福州外圍(福州外圍女)外圍上門(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 北京美女上門聯(lián)系方式(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 香港外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 昆明外圍價格查詢(微信181-2989-2716)昆明外圍女價格多少

- 南昌外圍(外圍上門)外圍女預(yù)約(電話微信181-2989-2716)一二線城市快速預(yù)約,30分鐘可以到達(dá)

- 揚(yáng)州同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 長沙包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 重慶外圍(外圍聯(lián)系方式)(電話微信181-2989-2716)全國1-2線熱門城市高端外圍預(yù)約快速安排30分鐘到達(dá)

- 蘇州外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 北京包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 上海外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 南京美女約炮(微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 湛頭模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 沈陽外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 深圳外圍(外圍預(yù)約)外圍女聯(lián)系方式(電話微信181-2989-2716)一二線熱門城市上門

- 南京包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 昆明兼職學(xué)生妹(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 常州外圍(外圍模特)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 重慶外圍(重慶外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海美女約炮(微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 麗江模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 青島外圍(外圍預(yù)約)(微信181-2989-2716)一二線城市有外圍資源網(wǎng)紅模特空姐留學(xué)生白領(lǐng)

- 寧波外圍(寧波外圍女)外圍預(yù)約(電話微信181-2989-2716)全國一二線熱門城市快速安排30分鐘到達(dá)

- 南京兼職大學(xué)生妹包養(yǎng)(微信181-2989-2716)提供全球及一二線城市兼職大學(xué)生妹包養(yǎng)外圍上門外圍女全套一條龍

- 廣州美女兼職上門外圍上門外圍女(微信181-2989-2716)全國1-2線城市可真實(shí)安排30分鐘到達(dá),不收任何定金

- 濟(jì)南兼職白領(lǐng)上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 臺州外圍(外圍預(yù)約)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市同城快速安排,30分鐘準(zhǔn)時到達(dá)

- 重慶包夜小三情婦(電話微信181-2989-2716)上門預(yù)約外圍上門外圍女全套一條龍供全球及一二線城市包養(yǎng)資源

- 北京外圍(外圍聯(lián)系方式)(電話微信181-2989-2716)全國1-2線熱門城市高端外圍預(yù)約快速安排30分鐘到達(dá)

- 濟(jì)南同城美女約炮(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 蘇州美女約炮(微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 麗江包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 廣州包夜美女(微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 南昌美女包養(yǎng)(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 青島外圍(外圍美女)外圍上門(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 臺州包養(yǎng)外圍上門外圍女上門外圍上門外圍女(電話微信181-2989-2716)怎么找空姐莞式外圍上門外圍女桑拿全套按摩高端模特特殊外圍上門外圍女

- 常州外圍價格查詢(微信181-2989-2716)常州外圍女價格多少

- 南京外圍(外圍預(yù)約)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市同城快速安排,30分鐘準(zhǔn)時到達(dá)

- 揚(yáng)州包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 北京外圍(外圍模特)電話微信181-2989-2716誠信外圍,十年老店

- 長沙美女兼職外圍上門外圍女(微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 麗江包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 上海美女上門聯(lián)系方式(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 上海包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 義烏外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 重慶外圍兼職價格(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 重慶包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 哈爾濱外圍(哈爾濱外圍女)(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 寧波外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 常州美女同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 北京包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 上海外圍(外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 深圳包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 揚(yáng)州美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 深圳外圍美女(電話微信181-2989-2716)提供頂級外圍,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 石家莊外圍(石家莊外圍女)外圍上門(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 蘇州外圍大圈伴游(微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 常州包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 海口包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 哈爾濱同城外圍約炮外圍上門外圍女(微信181-2989-2716)一二線城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 重慶美女快餐外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 上海外圍美女(電話微信181-2989-2716)提供頂級外圍,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 合肥外圍模特經(jīng)紀(jì)人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實(shí)可靠快速安排

- 廈門外圍價格查詢(微信181-2989-2716)廈門外圍女價格多少

- 合肥包夜美女外圍上門外圍女(電話微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 義烏外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 濟(jì)南外圍(外圍模特)電話微信181-2989-2716誠信外圍,十年老店

- 北京包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 青島同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 貴陽外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 鄭州外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 杭州同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 哈爾濱高端美女上門外圍上門外圍女(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 濟(jì)南外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 南昌外圍(南昌外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 福州包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 北京包夜學(xué)生妹(微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 義烏外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 南昌包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 寧波外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 天津外圍(天津外圍女)外圍外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 常州外圍(外圍聯(lián)系方式)(電話微信181-2989-2716)全國1-2線熱門城市高端外圍預(yù)約快速安排30分鐘到達(dá)

- 合肥包夜學(xué)生妹(微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 合肥包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 重慶包夜美女外圍上門外圍女(電話微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 常州同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 太原包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 義烏包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 貴陽包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 哈爾濱外圍預(yù)約上門(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 臺州包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 青島包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 常州外圍(常州外圍女)外圍預(yù)約(電話微信181-2989-2716)全國一二線熱門城市快速安排30分鐘到達(dá)

- 常州外圍(常州外圍女)電話微信181-2989-2716提供一二線城市高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 義烏外圍(外圍模特)電話微信181-2989-2716誠信外圍,十年老店

- 成都包夜美女(微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 臺州外圍女模特平臺(外圍模特)外圍女(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 杭州外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 貴陽包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 沈陽外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 重慶外圍(外圍美女)外圍女(電話微信181-2989-2716)一二線城市可以提供高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 北京包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 上海美女同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 貴陽外圍(外圍模特)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 長沙包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 麗江外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 義烏外圍(外圍美女)外圍聯(lián)系方式(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 石家莊外圍(石家莊外圍女)電話微信181-2989-2716提供一二線城市高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 義烏包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 廣州包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 南京包夜美女(微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 上海外圍女兼職價格(電話微信181-2989-2716)真實(shí)可靠快速安排

- 麗江包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 石家莊外圍(外圍預(yù)約)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市同城快速安排,30分鐘準(zhǔn)時到達(dá)

- 蘇州外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 廣州包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 重慶同城美女約炮(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 石家莊外圍(外圍美女)外圍聯(lián)系方式(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 上海包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 長春同城美女約炮(微信181-2989-2716)無套吹簫、配合各種姿勢

- 北京包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 南京包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 杭州包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 珠海包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 哈爾濱包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 哈爾濱外圍(外圍女)外圍上門(電話微信181-2989-2716)全國1-2線熱門城市快速安排30分鐘到達(dá)

- 武漢包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 重慶兼職學(xué)生妹(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 濟(jì)南高端美女上門外圍上門外圍女(微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 深圳美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 上海包夜美女(微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 杭州外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 太原外圍(外圍預(yù)約)(微信181-2989-2716)一二線城市有外圍資源網(wǎng)紅模特空姐留學(xué)生白領(lǐng)

- 北京外圍(外圍美女)外圍女(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 西安外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 麗江外圍(麗江外圍女)外圍外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 南京外圍(南京外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 深圳外圍(外圍經(jīng)紀(jì)人) 外圍空姐(電話微信181-2989-2716)高端質(zhì)量,滿意為止

- 臺州包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 深圳外圍(深圳外圍女)外圍預(yù)約(電話微信181-2989-2716)全國一二線熱門城市快速安排30分鐘到達(dá)

- 北京外圍(外圍預(yù)約)外圍女聯(lián)系方式(電話微信181-2989-2716)一二線熱門城市上門

- 海口外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 石家莊包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 鄭州外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 福州外圍(福州外圍女)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市快速安排,真實(shí)到達(dá)無任何定金

- 重慶同城包夜外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 杭州美女上門預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 杭州美女包養(yǎng)(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 義烏外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 武漢外圍(外圍女)外圍預(yù)約(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 常州包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 北京模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 深圳包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 臺州包夜美女(微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 麗江外圍(外圍美女)外圍女(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 福州外圍預(yù)約(外圍平臺)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 長春兼職空姐包夜外圍上門外圍女(微信181-2989-2716)兼職空姐包夜外圍上門外圍女緩交一夜情、全套一條龍外圍上門外圍女

- 北京同城外圍約炮外圍上門外圍女(微信181-2989-2716)一二線城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 廈門美女上門聯(lián)系方式(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 海口外圍大圈美女(微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 青島外圍女在線(微信181-2989-2716)預(yù)約自帶工作室外圍上門外圍女不收任何定金

- 廣州外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 太原美女約炮(微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 成都同城美女約炮(微信181-2989-2716)無套吹簫、配合各種姿勢

- 常州外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 西安外圍(外圍模特)電話微信181-2989-2716誠信外圍,十年老店

- 亞特蘭包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 南通包夜外圍(微信181-2989-2716)一二線城市模特空姐網(wǎng)紅學(xué)生上門

- 貴陽同城包夜外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 溫州外圍女兼職(電話微信181-2989-2716)提供1-2線城市快速安排,真實(shí)到達(dá)無任何定金

- 深圳同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 蘇州外圍(蘇州外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 太原外圍女兼職價格(電話微信181-2989-2716)真實(shí)可靠快速安排

- 太原包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 蘇州包養(yǎng)外圍上門外圍女上門外圍上門外圍女(電話微信181-2989-2716)怎么找空姐莞式外圍上門外圍女桑拿全套按摩高端模特特殊外圍上門外圍女

- 杭州外圍(外圍預(yù)約)外圍價格(電話微信181-2989-2716)鴛鴦浴水中簫、制服誘惑絲襪

- 杭州外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 北京美女同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 湛頭外圍(湛頭外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 西安兼職外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線城市高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 哈爾濱外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 揚(yáng)州美女上門預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 福州外圍(外圍經(jīng)紀(jì)) 外圍聯(lián)系(電話微信181-2989-2716)一二線城市快速安排上門外圍上門外圍女,全程30分鐘到達(dá)

- 杭州外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 太原包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 無錫外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 青島包夜學(xué)生妹(微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 常州外圍上門外圍女(微信181-2989-2716)真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 湛頭同城美女約炮(微信181-2989-2716)無套吹簫、配合各種姿勢

- 廈門外圍(廈門外圍女)外圍預(yù)約(電話微信181-2989-2716)全國一二線熱門城市快速安排30分鐘到達(dá)

- 太原外圍(太原外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海包夜美女外圍上門外圍女(微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 南昌外圍女靠譜(微信181-2989-2716)南昌外圍女那個靠譜啊

- 南通外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 武漢外圍(武漢外圍女)電話微信181-2989-2716提供一二線城市外圍預(yù)約、空姐、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 貴陽外圍價格查詢(微信181-2989-2716)貴陽外圍女價格多少

- 珠海外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 北京模特包夜(電話微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 揚(yáng)州外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 常州外圍(外圍女)外圍上門(電話微信181-2989-2716)全國1-2線熱門城市快速安排30分鐘到達(dá)

- 上海外圍(香港外圍女)外圍預(yù)約(電話微信181-2989-2716)全國一二線熱門城市快速安排30分鐘到達(dá)

- 武漢模特包夜(電話微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 杭州包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 福州美女上門預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 蘇州美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 南昌包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 北京外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 溫州外圍(外圍聯(lián)系方式)(電話微信181-2989-2716)全國1-2線熱門城市高端外圍預(yù)約快速安排30分鐘到達(dá)

- 成都同城上門外圍上門外圍女(微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達(dá)

- 西安外圍預(yù)約上門(電話微信181-2989-2716)安全可靠真實(shí)安排見人滿意付款

- 廈門外圍(外圍模特)外圍女(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達(dá)

- 長沙外圍(外圍經(jīng)紀(jì))外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 北京包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 南通包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 鎮(zhèn)江外圍(外圍模特)電話微信181-2989-2716誠信外圍,十年老店

- 湛頭包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 湛頭兼職外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線城市高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 石家莊兼職白領(lǐng)上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 海口同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 深圳包夜學(xué)生妹(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 貴陽包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 長沙外圍(外圍美女)外圍女(電話微信181-2989-2716)一二線城市可以提供高端外圍預(yù)約,快速安排30分鐘到達(dá)

- 揚(yáng)州外圍(外圍預(yù)約)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市同城快速安排,30分鐘準(zhǔn)時到達(dá)

- 太原外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 上海同城美女預(yù)約外圍上門外圍女(微信181-2989-2716)提供全套一條龍外圍上門外圍女

- 三亞兼職大學(xué)生妹包養(yǎng)(微信181-2989-2716)提供全球及一二線城市兼職大學(xué)生妹包養(yǎng)外圍上門外圍女全套一條龍

- 沈陽包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 貴陽模特包夜(微信181-2989-2716)提供一二線城市可以真實(shí)可靠快速安排30分鐘到達(dá)

- 麗江外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 深圳包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 義烏提包夜美女(微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 蘇州包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 太原外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 長春同城美女約炮(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 鎮(zhèn)江包夜外圍(微信181-2989-2716)一二線城市模特空姐網(wǎng)紅學(xué)生上門

- 武漢外圍(外圍模特)電話微信181-2989-2716誠信外圍,十年老店

- 鄭州外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 濟(jì)南同城包夜外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 深圳同城外圍上門外圍女上門(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 成都同城包夜外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 北京同城外圍上門外圍女上門(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 臺州外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 青島外圍預(yù)約平臺(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 鎮(zhèn)江包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 青島包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 鄭州包夜外圍外圍上門外圍女(微信181-2989-2716)一二線熱門城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 南通外圍美女(電話微信181-2989-2716)提供頂級外圍,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 南昌美女上門預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 廣州同城外圍約炮外圍上門外圍女(微信181-2989-2716)一二線城市上門真實(shí)可靠快速安排30分鐘到達(dá)

- 常州包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 珠海外圍(珠海外圍女)外圍外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 太原外圍價格查詢(微信181-2989-2716)太原外圍女價格多少

- 石家莊美女兼職上門外圍上門外圍女(微信181-2989-2716)全國1-2線城市可真實(shí)安排30分鐘到達(dá),不收任何定金

- 廣州包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 深圳同城包夜外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 鎮(zhèn)江同城上門外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 貴陽外圍(外圍美女)外圍女(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 湛頭包夜小三情婦(電話微信181-2989-2716)上門預(yù)約外圍上門外圍女全套一條龍供全球及一二線城市包養(yǎng)資源

- 長春外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 鄭州外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 濟(jì)南外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 深圳外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 哈爾濱外圍(外圍經(jīng)紀(jì)人) 外圍空姐(電話微信181-2989-2716)高端質(zhì)量,滿意為止

- 臺州外圍(外圍模特)電話微信181-2989-2716誠信外圍,十年老店

- 北京同城外圍上門外圍女上門(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 湛頭美女約炮(微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 北京包夜空姐預(yù)約(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 上海外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 鄭州外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 廈門外圍兼職價格(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 北京大圈外圍聯(lián)系方式(微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 杭州外圍模特預(yù)約(外圍經(jīng)紀(jì)人)外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 武漢同城上門外圍上門外圍女(微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達(dá)

- 長春外圍(外圍經(jīng)紀(jì))外圍女(電話微信181-2989-2716)真實(shí)上門外圍上門外圍女快速安排30分鐘到達(dá)

- 上海包夜學(xué)生妹(微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 臺州外圍上門外圍女(微信181-2989-2716)真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 重慶包養(yǎng)外圍上門外圍女上門外圍上門外圍女(微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 溫州美女上門聯(lián)系方式(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 沈陽外圍(外圍模特)外圍女(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達(dá)

- 臺州外圍(外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 海口包夜美女全套外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 蘇州兼職網(wǎng)紅上門外圍上門外圍女(微信181-2989-2716)提供一二線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 長沙外圍(外圍上門)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實(shí)靠譜快速安排不收定金見人滿意付款

- 長春外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)

- 溫州外圍(溫州外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 太原外圍模特聯(lián)系方式(微信181-2989-2716)提供1-2線城市真實(shí)上門外圍上門外圍女,快速安排30分鐘到達(dá)

- 福州包夜外圍上門外圍女姐(微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 重慶外圍(重慶外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 常州外圍模特經(jīng)紀(jì)人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實(shí)可靠快速安排

- 蘇州外圍兼職價格(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 廣州高端美女上門外圍上門外圍女(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 常州同城包夜外圍上門外圍女(微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 南昌美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達(dá)

- 上海外圍預(yù)約(外圍模特)外圍上門(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達(dá)